El término Big Data es una tecnología digital de la que habrás oído hablar en infinidad de ocasiones, y te aseguramos que seguiremos haciéndolo por mucho tiempo. Y es así debido a que el análisis de datos masivos es una herramienta de gran utilidad para las empresas, incluido en la robótica. Disponer de una gran base de datos o conjunto de datos les otorga capacidad de análisis y de interpretación de los datos estructurados.

Definición de Big Data

Una definición sencilla del Big Data sería el uso de tecnología digital que es capaz de capturar un gran volumen de información que, por medio de herramientas tradicionales, sería inviable su gestión y procesamiento. Sin embargo el Big Data es mucho más complejo y por eso te invitamos a que leas este extenso artículo que hemos preparado.

¿Qué es el Big data?

Por definición el Big Data es el conjunto de datos representados en volúmenes que crecen a gran velocidad y que contienen una mayor variedad de información para que los softwares y los analistas puedan gestionarlos. Es decir, es el conjunto de información procedente de nuevas fuentes de datos que se encuentran formados por un grupo de datos complejo y de gran tamaño.

Un software de procesamiento de datos convencional no puede gestionar este gran volumen de información. Sin embargo ahora, estos volúmenes masivos se pueden gestionar para abordar problemas empresariales a los que antes no se les podía ofrecer soluciones eficientes.

Por poner un caso de éxito reciente, un programa con algoritmos de Inteligencia Artificial fue el primero en dar la voz de alarma de la existencia del Covid-19. Y lo hizo antes que las propias autoridades de Wuhan, en la provincia de Hubei, en China. La startup creadora del programa se llama Blue Dot, y como ya comentamos en el artículo que publicamos meses atrás, lo hizo gracias a que rastreaba la información sanitaria que se produce diariamente en todo el mundo. Hace tan solo un para de décadas habríamos necesitado a miles de personas para realizar ese seguimiento, mientras que ahora, una herramienta de código abierto puede hacer esa tarea por nosotros.

Para que nos hagamos una idea de la capacidad del Big Data. Según los expertos y profesionales del sector, se entiende que un conjunto de datos procesados llega a ser Big Data cuando gestiona desde los 30-50 terabytes a los petabytes (PB). Por si no tienes claro que son estas unidades de medida vamos a repasarlas. Un petabyte es poco más de 1 millón de gigabytes y un terabyte son 1.000 gigabytes. Pues bien, Facebook gestiona al día 500 terabytes de datos y simplemente la bolsa de Nueva York gestiona a diario 1 Petabytes. ¿Asusta?

Ejemplos y aplicaciones de Big data

Cada vez son más las empresas que utilizan aplicaciones de Big Data para dirigirse mejor a sus clientes con productos más eficaces. Algunos ejemplos de análisis de datos en las actividades empresariales son:

- Desarrollo de productos comerciales

- Anuncios publicitarios personalizados mediante Marketing optimizado

- Resolución de problemas TI

- Análisis de los Call Center o servicios de Atención al Cliente

- Mantenimiento predictivo de sistemas, máquinas y robots

- Análisis de experiencia de usuario en aplicaciones y en ecommerce

- Gestiones administrativas más eficientes

- Detección y prevención de fraudes fiscales.

- Las compañías de seguros disponen de una información más amplia de sus clientes

- Gestión de los problemas de salud a nivel global y detección precoz de pandemias

- Ofrecer en el sector turístico paquetes más eficientes

- Eficiencia operativa de gestión y producción.

- Detección y desarrollo de productos innovadores.

- Gestión e interpretación de los mercados financieros internacionales.

- Mejoran los controles calidad supervisados con Visión Artificial

Características del Big data

La complejidad de analizar grandes bases de datos se debe a una característica fundamental, y es que los datos normalmente llegan de manera no estructurada. Es el caso de la información que llega desde nuestros dispositivos electrónicos, búsquedas de internet, preferencias, gustos, desplazamientos, actividad en Redes Sociales, aparatos inteligentes, etc…

Por ese motivo necesitamos herramientas que nos ofrezcan ventajas ante semejante cantidad de información y dificultades que conlleva, como son:

- Volumen: la gran cantidad de datos se definen Big Data cuando el procesamiento, almacenamiento y explotación comienza a ser un reto para una organización o empresa cuando supera el tamaño definido.

- Velocidad: esta característica se ve dada por la relación que tiene el ritmo en que los datos se generan, los cuales aumentan de manera constante necesitando una respuesta en tiempo real.

- Variedad: en esta característica existe una gran diversidad de formatos, en donde se hallan datos que pueden ir desde textos simples, videos, imágenes, hojas de cálculos, y bases de datos enteras.

- Veracidad: en este aspecto los datos deben ser confiables y mantenerse limpios. Si estos datos no son correctos no tienen valor alguno y pueden ser muy perjudiciales, en especial en la toma de decisión automatizada.

- Valor: esta característica es donde finalmente, los datos con su respectivo análisis deben generar un gran beneficio para la empresa.

Por qué es importante el Big Data y ventajas de su uso

El uso del Big Data almacenándolo en la nube (Cloud) ofrece a las empresas y organizaciones la capacidad de aprovechar los datos que se están generando diariamente.

- Desarrollar estrategias en tiempo real

- Optimización de las acciones mediante la analítica

- Aumenta los beneficios mediante estrategias más personalizadas

- Reduce el coste de los procesos al estar automatizados

- Favorece la creación de nuevos productos

- Mejora la competitividad de las empresas

Para qué sirve el estudio de datos masivos

El estudio de análisis masivos de datos normalmente pertenece al comportamiento y la forma de interactuar de las personas, aunque como veremos posteriormente, esta tecnología tiene infinidad de aplicaciones sociales y laborales, principalmente en la Industria 4.0.

Gracias a que el Big data gestiona un gran volumen de información, permite la obtención de respuestas complejas, eficientes, y rápidas. Estas respuestas ofrecen soluciones desde un enfoque distinto a los problemas, y siempre desde la fiabilidad de la analítica de los datos.

Cómo funciona el Big data o los microdatos

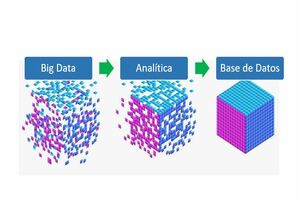

Son tres acciones claves las que se requieren para que el Big data aporte nuevas perspectivas que brinden nuevas oportunidades y modelos de negocio en la automatización, y son:

Integrar: mecanismos de integración de datos convencionales, tales como ETL no están a la altura de cumplir esta tarea. Analizar conjuntos de Big data de 1 o más terabytes o petabytes de gran tamaño requiere de nuevas tecnologías y estrategias. Por ello es necesario incorporar estos datos, procesarlos y asegurarse que se formateen, y disponerlos de manera tal que los analistas empresariales puedan comenzar a utilizarlos.

Gestionar: Este apartado hace referencia a la gestión de los datos y para ello se requiere de un espacio de almacenamiento, el cual puede residir en la nube. Estos datos se pueden almacenar de cualquier forma para que luego se incorporen los requisitos del proceso. Muchos eligen almacenar en función de donde residen sus datos en cada momento.

Analizar: los modelos de datos son procesados y reconstruidos mediante algoritmos de Aprendizaje Automático (Machine Learning) de Inteligencia Artificial. Su capacidad de detección de patrones y de procesamiento de datos ofrece información estructurada a los analistas.

Herramientas del Big Data

Es necesario utilizar herramientas en continua evolución que abarquen la complejidad de los datos estructurados y los no estructurados. Por tal motivo, se requiere tecnología avanzada capaz de analizar y extraer estos datos con el fin de procesarlos para alcanzar los objetivos de un negocio. Las principales herramientas que se utilizan para el Big data son:

- Apache Hadoop

- Piq

- Hive

- Apache Cassandra

- Apache Spark

- Apache Kafta

- Apache Lucene

- Apache Zeppelin

- Elasticsearch

- TensorFlow

- Storm

- Hive

- R

- D3.js

- NoSQL

Estas herramientas que aparecen en la lista tienen características independientes entre sí, por lo que se usa una u otra en función de las necesidades del cliente. Por ejemplo Hadoop, es probable que sea la más utilizada para el sector de las finanzas, mientras que Spark destaca por ser muy rápida, ya que tiene la particularidad de que te permite almacenar parte de los datos en la memoria y en el disco de una máquina local. De Apache Kafka podemos resaltar que permite realizar operaciones en tiempo real o en streaming. Elasticsearch es más bien un motor de búsqueda empresarial que extrae información de datos estructurados y no estructurados, mientras que TensorFlow es una biblioteca que se utiliza para el Aprendizaje Automático (Machine Learning).

Estos son probablemente los más extendidos, aunque existen más en el mercado. También hay que recordar que muchos de estos softwares, como es el caso de Apache Hadoop, son de código abierto.

Historia del Big data

El concepto de Big Data es relativamente nuevo, pero a la década de los 60 y 70 se remontan los orígenes de análisis de grandes conjuntos de datos, donde en este mundo comenzaban con los primeros centros de información y el desarrollo de las mismas.

A través de Facebook, Youtube y otros servicios, los usuarios generaban gran cantidad de datos alrededor del 2005. En ese mismo año se desarrolló Hadoop (un marco de código abierto), creado para analizar y almacenar grandes conjuntos de datos. El desarrollo de este marco de código abierto fue primordial en el crecimiento del Big Data, haciendo de este proceso sencillo de utilizar y económico para almacenar.

Actualmente y con la incorporación de tecnologías como el 5G, el volumen de información se ha incrementado exponencialmente. Como consecuencia los usuarios generan gran cantidad de datos, aunque estos no son los únicos. La existencia de Internet ha contribuido a que un mayor número de dispositivos estén conectados mediante Internet of Things (Internet de las Cosas), generando mayor número de información que muestran patrones de conducta y comportamiento.

Tipos de Big data o microdatos

Es importante señalar que existen diversos tipos de datos que se asocian al Big data, que a la hora de clasificarlos, se pueden hacer según dos criterios: estructura y procedencia.

Datos según su procedencia:

- La web y redes sociales: información que se encuentra disponible en la web, la cual se genera por usuarios en las redes sociales o la información de búsqueda en los buscadores.

- Machine to Machine: son los datos generados a través de la comunicación entre dispositivos inteligentes y objetos de uso cotidiano.

- Transacciones: estos datos incluyen diversos registros de facturación, transacciones o llamadas entre cuentas.

- Biométricos: estos datos se generan por tecnología que identifican personas a través de reconocimiento facial, información genética o huellas dactilares.

- Generados por personas: estos datos son generados a través de servicio de mensajería, correos electrónicos o grabaciones de llamadas.

- Generados por organizaciones: organizaciones públicas y privadas son las que generan este tipo de datos y se relacionan con el medio ambiente, estadísticas sobre economía, población, historiales clínicos, etc.

Tipos de datos en función de su estructura

- Estructurados: las bases de datos relacionales, las cuales tienen definido su tamaño, longitud y formato.

- Semiestructurados: datos como XML y HTML, JSON, y las hojas de cálculo como Excel, son almacenados con metadatos definidos y una estructura flexible.

- No estructurados: ficheros de texto como Word, PDF, correos electrónicos o contenido multimedia como audio, vídeo, o imágenes, que contienen datos sin formato específico.

Mejores prácticas de Big data

Para lograr crear una base de Big Data con éxito, es necesario tomar en cuenta una serie de prácticas:

- Alinear Big Data con objetivos empresariales específicos.

- Reducir la falta de habilidades con estándares y administración.

- Mejorar la transferencia de conocimientos.

- Ordenar datos estructurados y no estructurados.

- Proyectar el laboratorio de hallazgos.

- Ordenarlo con el modelo operativo en la nube.

En la actualidad una de las mejores alternativas laborales es aprender Lenguaje de Programación y el análisis de datos masivos. Por ello son muchos los cursos universitarios, máster y posta grados que se están creando para formar a los profesionales de hoy y del mañana, ya sea en herramientas relacionadas con la Inteligencia Artificial o con el Big Data.

Revista de Robots te recomienda:

- Conoces los Vehículos de Guiado Automático AGV

- Ventajas de los robots Colaborativos

- Marcas de Robots Industriales

- Impresoras 3D con impresión en resina y metal